Prompt(提示词)是大模型理解任务的“编程语言”,是人与AI交互的核心接口。与传统编程不同,Prompt通过自然语言指令控制模型行为,其本质是语义特征提取器——将用户意图转化为模型可解析的隐空间向量。

案例对比:

模糊指令:

“写一篇关于气候变化的文章”

→ 输出内容宽泛,缺乏深度

工程化Prompt:

“你是一名联合国环境署专家,用Markdown格式撰写报告,需包含:1) 近5年北极冰盖面积变化数据(引用IPCC报告)

2) 对发展中国家的影响分析

3) 三个可落地的解决方案。字数限制2000字,避免专业术语。”

→ 输出结构清晰,数据准确,可读性强

技术必要性:

模型控制:GPT-4的1750亿参数需精确引导

成本优化:优秀Prompt减少30%的API调用次数

安全合规:通过Prompt约束输出内容(如过滤敏感信息)

商业价值:

某电商客服系统通过Prompt优化,问题解决率从58%提升至82%

法律咨询AI的Prompt工程使合同审核效率提升6倍

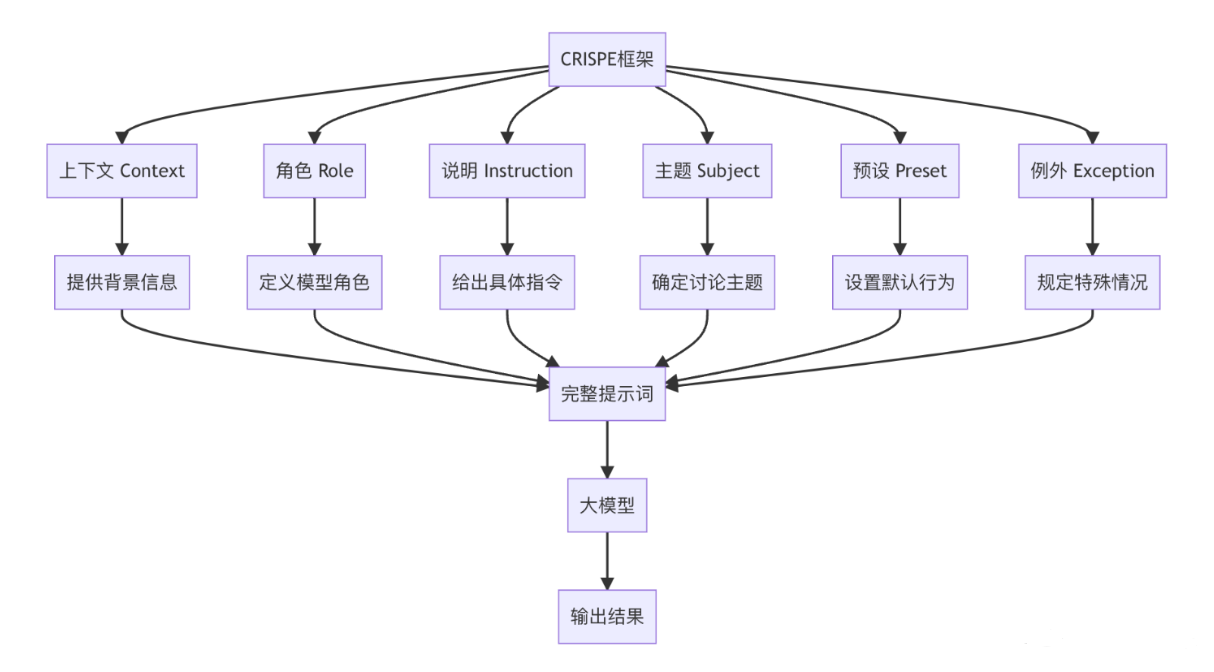

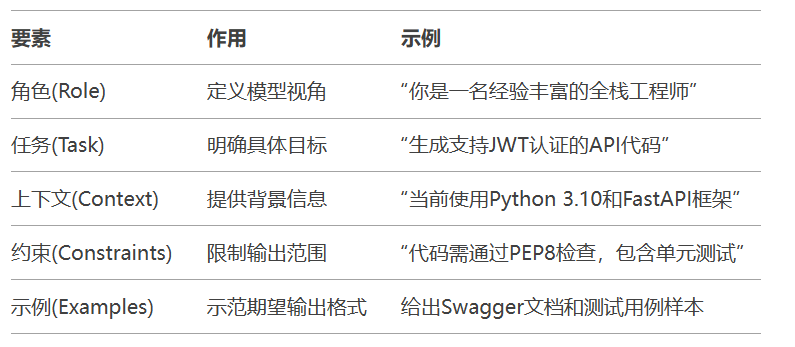

四层架构模型:

角色定义层:设定模型身份(如“资深Python工程师”)

任务描述层:明确目标(如“开发Flask RESTful API”)

约束条件层:格式/长度/风格限制(如“使用OpenAPI 3.0规范”)

示例参考层:提供输入-输出样本(如给出Swagger文档样例)

技术原理:

KV缓存机制:模型通过Key-Value向量存储对话历史

注意力权重分配:根据相关性动态调整历史信息权重

工业级应用:

# 伪代码:上下文窗口管理 class ContextWindow: def __init__(self, max_tokens=8000): self.buffer = [] self.max_tokens = max_tokens def update(self, new_input): while self._calc_tokens() + len(new_input) > self.max_tokens: self.buffer.pop(0) # 先进先出淘汰 self.buffer.append(new_input) def get_context(self): return "\n".join(self.buffer)

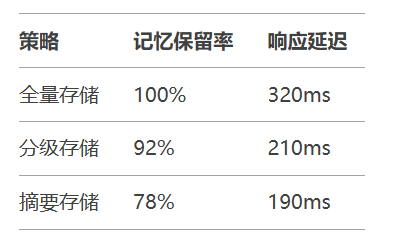

3.2 上下文窗口优化策略

分级存储技术:

热数据:最近3轮对话(完整保留)

温数据:关键实体信息(向量化压缩存储)

冷数据:历史背景(摘要存储)

性能对比:

Specific(具体):

❌ “优化代码”

✅ “将Python循环改为向量化操作,提升Pandas处理速度”

Measurable(可衡量):

# 在Prompt中嵌入评估指标 prompt = """ 重构以下函数,要求: - 执行时间减少50%(原函数平均耗时120ms) - 内存占用控制在100MB以内 """

4.2 角色扮演:领域专家模式

法律咨询Prompt示例:

[角色] 你是金杜律师事务所高级合伙人,专注公司法领域15年 [任务] 审核以下股权转让协议,重点检查: 1. 优先购买权条款合规性 2. 违约责任条款的可执行性 3. 税务筹划方案的合法性 [输出要求] 使用表格列出风险点(含法律依据),按风险等级排序

4.3 格式化输出:结构约束

Markdown模板控制:

请生成GitHub风格的技术文档,包含:

```markdown

# {项目名称}

## 功能特性

- [ ] 待实现

- [x] 已完成

## API端点

```python

@app.get("/items/{item_id}")

async def read_item(item_id: int):

return {"item_id": item_id}

```4.4 提供样本:Few-shot Learning

代码生成示例:

根据以下示例生成新函数: 输入示例: def add(a: int, b: int) -> int: \"\"\"两数相加\"\"\" return a + b 新需求: 编写一个函数计算阶乘,要求: - 使用递归实现 - 添加类型注解 - 包含文档字符串

4.5 思维链(Chain-of-Thought)

数学推理应用:

请分步解答以下问题: 问题: 鸡兔同笼,共有头35个,脚94只,求鸡兔各多少? 解答步骤: 1. 设鸡的数量为x,兔的数量为y 2. 根据题意列出方程: x + y = 35 2x + 4y = 94 3. 解方程组得...

4.6 框架化思维:模板引擎

企业级Prompt模板:

[System] 你是一个{角色},擅长{领域}

[Instruction] 需要完成以下任务:

- 主要目标:{目标描述}

- 关键要求:{要求列表}

[Constraints]

- 输出格式:{格式规范}

- 避免内容:{禁忌项}

[Examples]

输入:{示例输入}

输出:{示例输出}Prompt本质:控制大模型行为的元编程语言

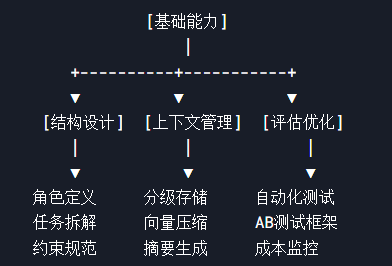

结构要素:角色→任务→约束→示例的四层架构

上下文管理:分级存储+动态压缩技术

六大技巧:目标SMART化、角色专业化、格式模板化、样本引导、思维链分解、框架标准化

❌ 提示词过于模糊(如“写得好一点”)

❌ 忽略模型上下文长度限制

❌ 缺乏可验证的评估标准

def evaluate_prompt(response): # 检查代码规范性 if "PEP8" in requirements: run_flake8(response) # 验证性能指标 if "execution_time < 100ms": benchmark_test(response)

5.4 未来发展方向

动态Prompt生成:基于用户画像实时构建最优提示

多模态Prompt:融合文本/图像/语音的混合指令

强化学习优化:自动探索最佳Prompt组合

提示词工程技能图谱:

掌握提示词工程需要持续实践:建议从修改现有Prompt开始(如优化ChatGPT对话),逐步构建自己的Prompt库。进阶者可尝试LangChain等框架实现Prompt自动化流水线,最终达到工业级部署能力。