废话不多说,分重点给大家介绍 17种提示词规则方法,带你一起体验提示工程的魅力。

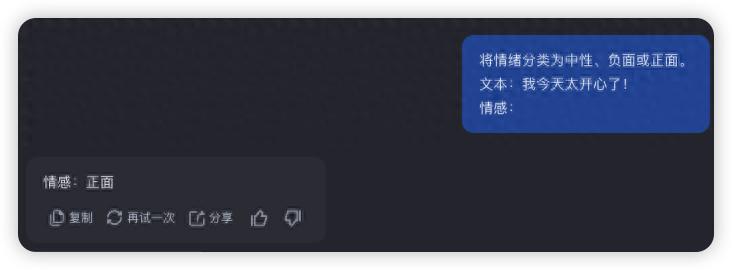

可在没有提供任何示例的情况下,直接指示模型完成任务的方法。核心思想是,凭借大模型在海量数据中学习到的通用知识和能力,直接理解任务要求并给出正确的答案。

# prompt将情绪分类为中性、负面或正面。

文本:我今天太开心了!

情感:

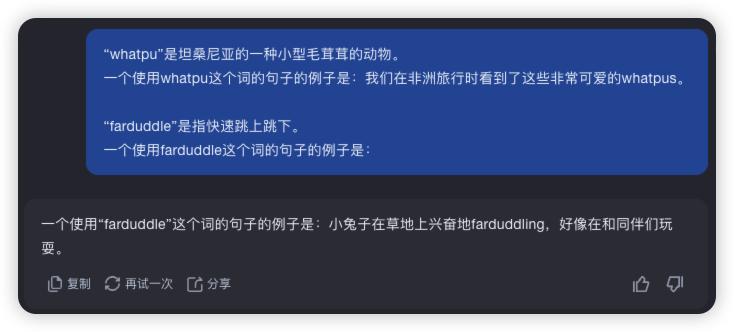

利用大型语言模型 (LLM) 的能力,通过在提示词中提供少量示例,来引导模型完成特定任务的方法。与零样本提示不同,少样本提示通过示例来帮助模型理解任务的模式和规则,进而更准确地生成符合要求的输出。

# prompt“whatpu”是坦桑尼亚的一种小型毛茸茸的动物。 一个使用whatpu这个词的句子的例子是:我们在非洲旅行时看到了这些非常可爱的whatpus。 “farduddle”是指快速跳上跳下。 一个使用farduddle这个词的句子的例子是:

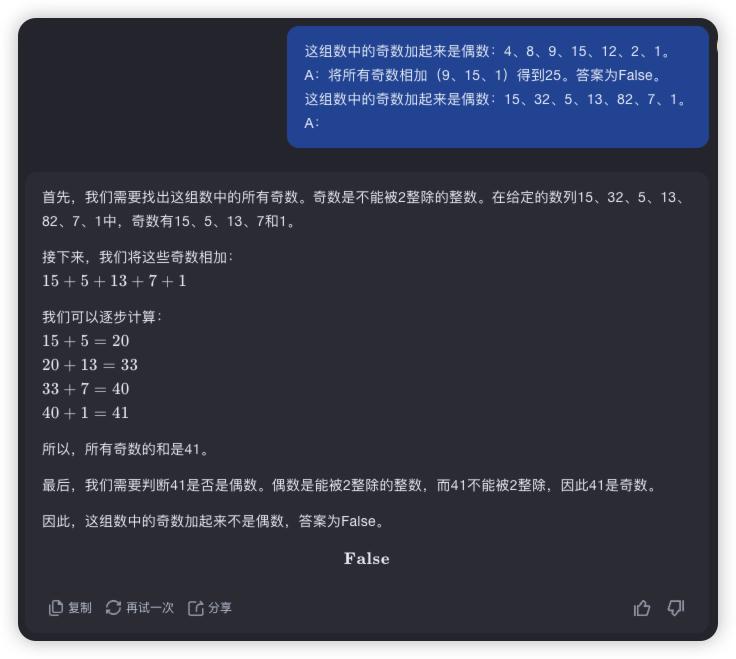

通过在提示词中引导大型语言模型 (LLM) 逐步进行推理,来解决复杂问题。CoT 提示鼓励模型一步一步地思考,模拟人类的推理过程,从而提高多步推理和逻辑分析类任务的表现。

# prompt这组数中的奇数加起来是偶数:4、8、9、15、12、2、1。 A:将所有奇数相加(9、15、1)得到25。答案为False。 这组数中的奇数加起来是偶数:15、32、5、13、82、7、1。 A:

更夸张的是,只需要把「让我们逐步思考」加入进去,就可以起效。这种称之为「零样本 COT 提示」。

# 反面案例# prompt我去市场买了10个苹果。我给了邻居2个苹果和修理工2个苹果。然后我去买了5个苹果并吃了1个。我还剩下多少苹果?# output1个苹果# 利用COT得到正确答案# prompt我去市场买了10个苹果。我给了邻居2个苹果和修理工2个苹果。然后我去买了5个苹果并吃了1个。我还剩下多少苹果?让我们逐步思考。# output首先,您从10个苹果开始。您给了邻居和修理工各2个苹果,所以您还剩下6个苹果。然后您买了5个苹果,所以现在您有11个苹果。最后,您吃了1个苹果,所以您还剩下10个苹果。

现在很多模型已经暗含了 COT 模式,分析非常细。

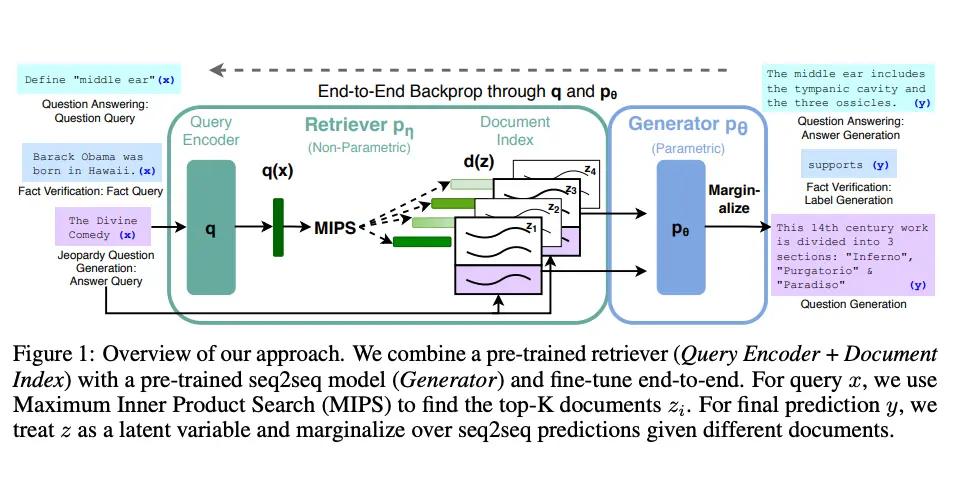

通过结合外部知识库的检索和大型语言模型 (LLM) 的生成能力,来提高LLM在知识密集型任务上的表现。

RAG 先从外部知识库中检索相关信息,然后利用检索到的信息进行生成,从而实现与事实更加一致,生成的答案更可靠,还有助于缓解「幻觉」问题。

使用 LangChain 构建 RAG(检索增强生成)应用:

https://python.langchain.com/docs/tutorials/rag/

主要包括以下步骤:

加载文档 (Loading documents): 从各种来源加载数据,例如文本文件,网页等。 分割文本 (Splitting text): 将文档分割成更小的文本块,以便于检索。 创建向量嵌入 (Creating embeddings): 将文本块转换为向量表示,以便于计算相似度。 存储向量 (Storing vectors): 将向量存储到向量数据库中,以便于快速检索。 检索相关文档 (Retrieving relevant documents): 使用用户的查询从向量数据库中检索相关的文本块。 利用LLM生成答案 (Generate answer with LLM): 将检索到的文本块和用户查询组合成提示,并使用 LLM 生成最终答案。

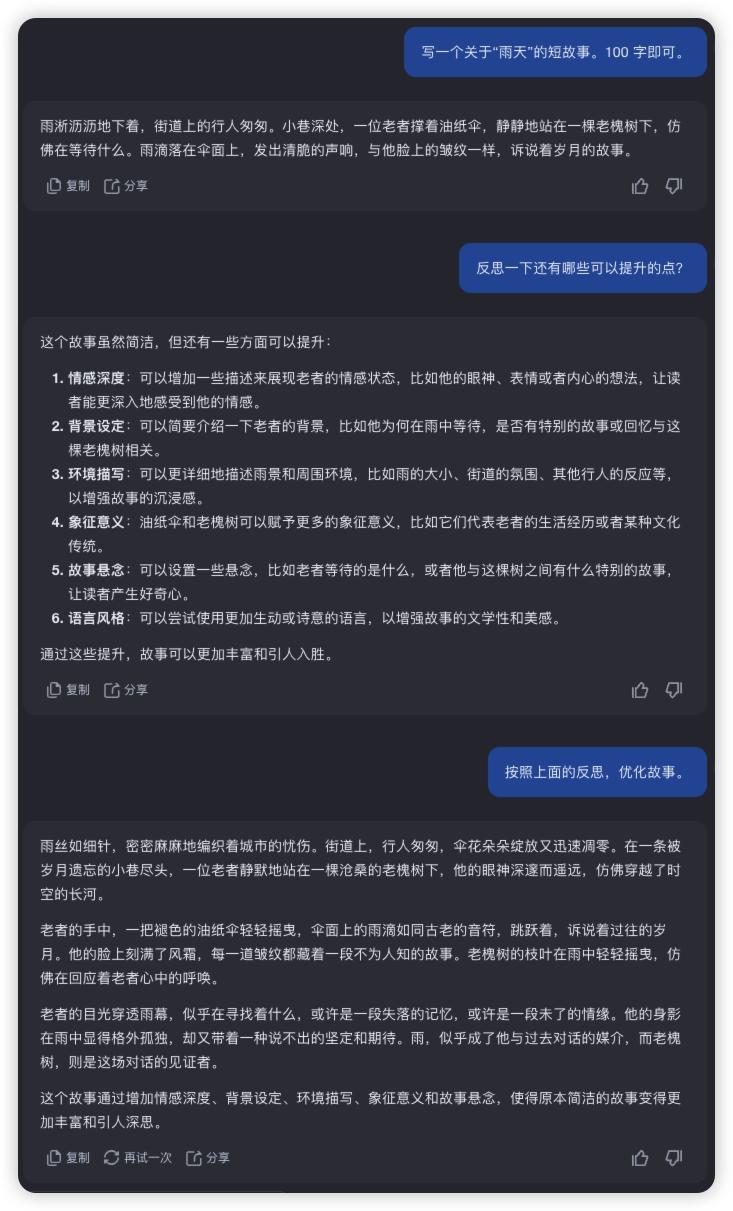

通过让大型语言模型 (LLM) 对其自身的输出进行反思和迭代,来提高LLM在复杂任务上的表现。 反思提示鼓励模型先生成一个初步答案,然后对该答案进行评估和反思,再反思结果进行改进,迭代生成最终的答案。

除了上述 5 个规则,还有 12 个重要的规则如下:

但本人使用的频率不高,所以篇幅限制就不在此展示了。

AI 目前还是非常考验使用者的。

如果掌握了更多的底层方法论,就能更好的融入日常工作。