当前AI智能体技术已从单一任务执行向多智能体协同进化。本文将系统拆解智能体架构设计的九大核心技术,覆盖基础架构、协作机制与交互协议三层体系,并配图详解实现方案。

一、基础层:智能体核心能力构建

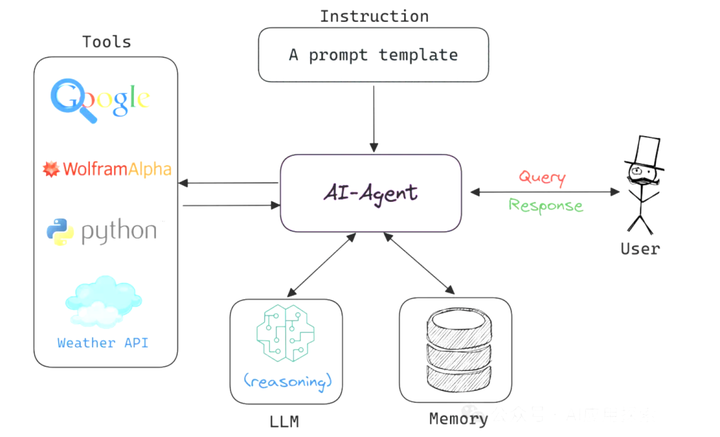

1. AI智能体本体架构

AI智能体是具备环境感知、逻辑决策和动作执行的自主软件。其核心工作流包含四个关键组件:

Prompt指令层:定义LLM可调用的工具集,输出JSON格式的动作指令

Switch逻辑路由:解析LLM输出并分配执行路径

上下文累积器:记录历史动作及结果的状态存储器

For循环驱动引擎:循环执行直至返回终止信号(如"Terminal"标记)

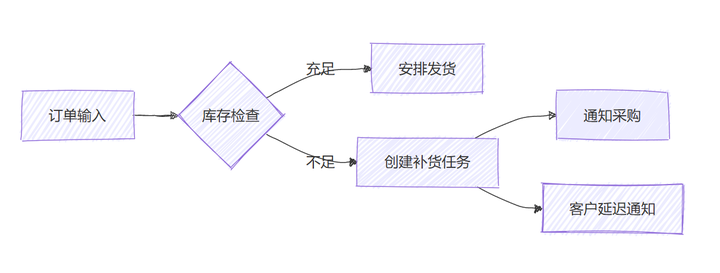

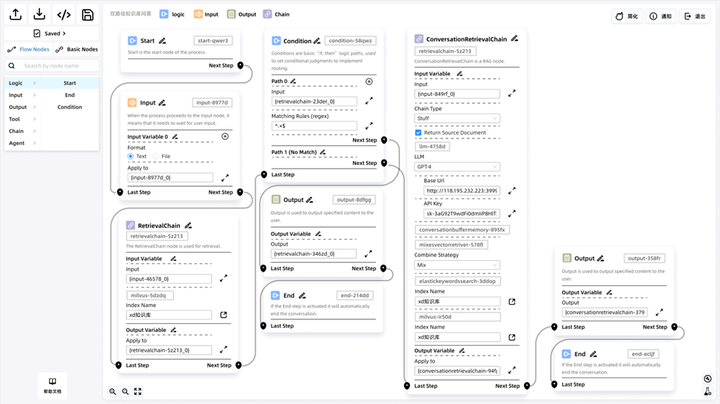

2. 工作流引擎(WorkFlow)

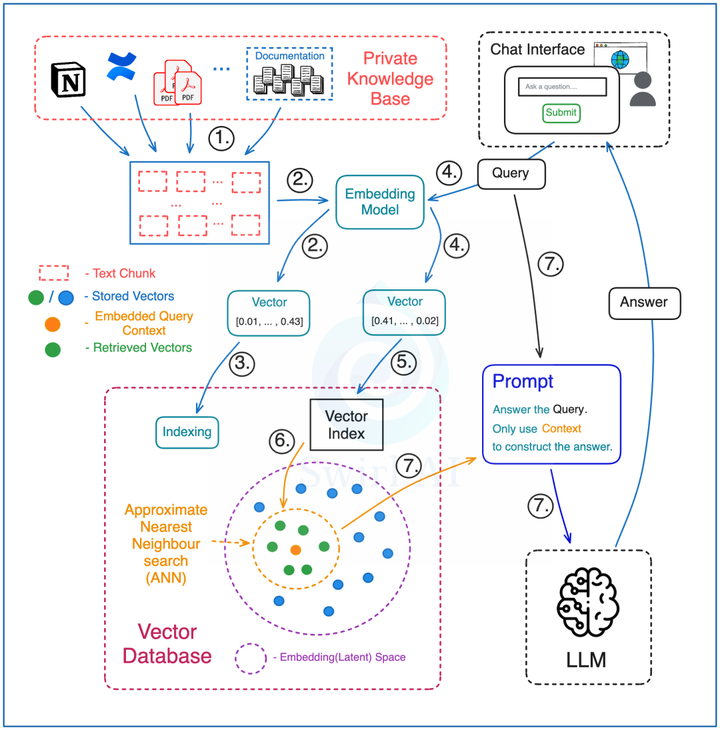

3. RAG增强检索

解决大模型知识滞后问题的标准架构:

# 预处理阶段

chunks = split_documents(knowledge_base)

embeddings = embed_model.encode(chunks)

vector_db.index(embeddings, metadata=chunks)

# 检索阶段

query_embed = embed_model.encode(user_query)

results = vector_db.search(query_embed, top_k=5)

response = llm(prompt_template(query, results))

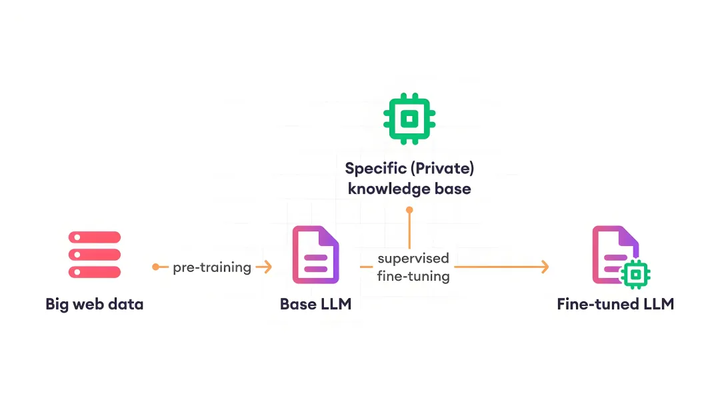

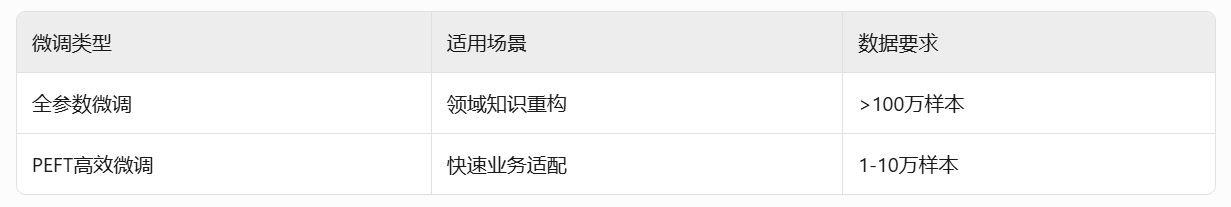

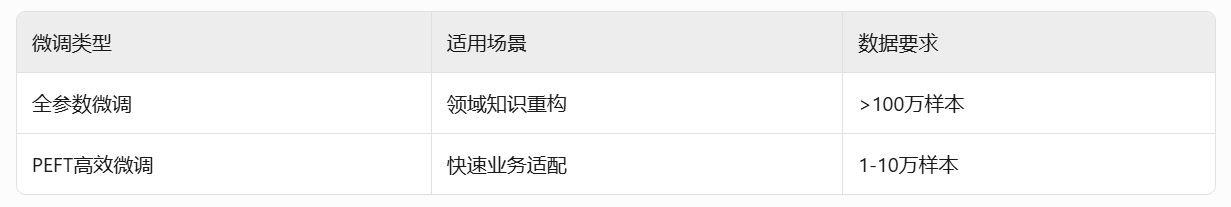

4. 大模型微调(Fine-tuning)

企业级落地的关键技术路径:

5. 函数调用(Function Calling)

// LLM返回的函数调用指令

{

"function": "get_weather",

"params": {"location": "北京", "unit": "celsius"}

}Function Calling 是一种强大的工具,它为大语言模型提供了与外部工具和服务交互的能力,从而解决了大模型知识更新停滞的问题。然而,它的局限性在于缺乏跨模型的一致性和平台依赖性。尽管如此,Function Calling 仍然是一个重要的技术,尤其是在需要快速实现特定功能时。未来,随着技术的不断发展,我们期待看到更多能够克服这些局限性的解决方案。

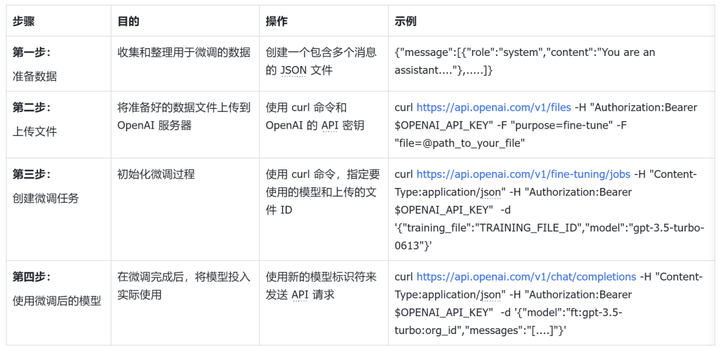

二、协作层:多智能体系统架构

6. Agentic AI协作框架

如果将 AI 智能体比作独奏者,那么 Agentic AI 就像是一个交响乐团。在Agentic AI 系统中,每个 AI 智能体都有其独特的角色和能力,它们可以相互协作、共享信息,并根据任务需求动态调整策略。这种协作模式让系统能够应对那些超出单个 AI 智能体能力范围的复杂任务。

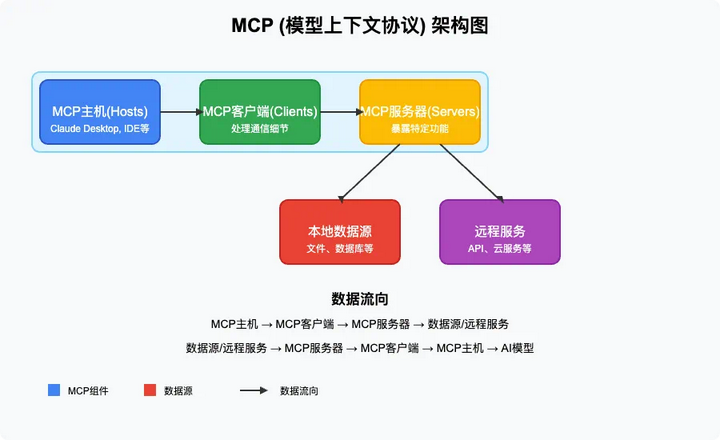

7. MCP协议(Model Context Protocol)

目前,MCP 生态已经得到了广泛的支持,包括 Anthropic 的 Claude 系列、OpenAI 的 GPT 系列、Meta 的 Llama 系列、DeepSeek、阿里的通义系列以及 Anysphere 的 Cursor 等主流模型均已接入 MCP 生态。

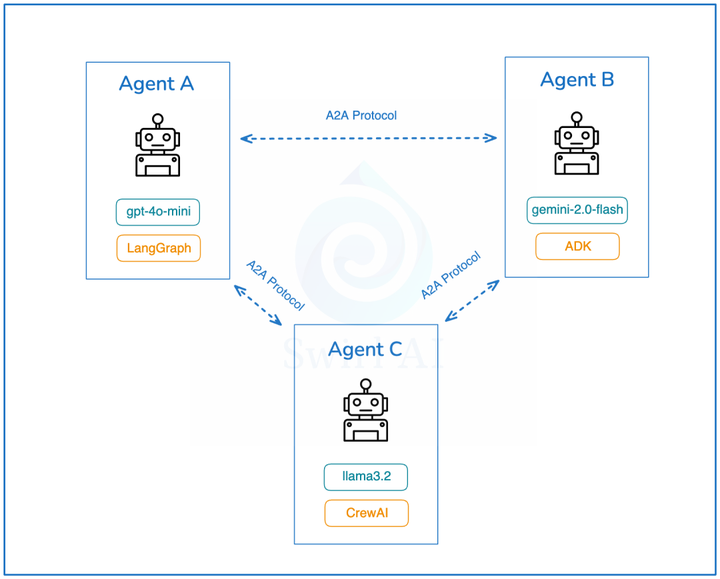

8. A2A协议(Agent-to-Agent)

谷歌主导的智能体通信标准:

能力发现:通过Agent Card公开服务目录

任务协商:支持长时任务的状态同步机制

跨平台兼容:基于HTTP/SSE/JSON-RPC实现

三、交互层:人机协同协议

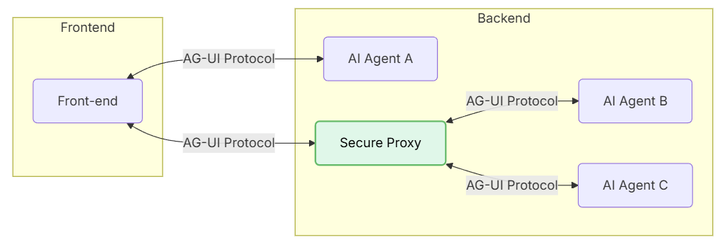

9. AG-UI交互协议

前端与智能体的双向通信标准:AG-UI 完善了 AI 协议栈,专注于构建 AI 智能体与用户前端之间的桥梁。它采用事件驱动的设计,定义了16种标准事件,并支持 SSE、WebSocket 和 Webhook 等传输方式,与 LangGraph、CrewAI 等框架兼容。

TASK_START:任务启动

TOOL_CALL:工具调用通知

PARTIAL_RESULT:流式返回片段

AWAITING_INPUT:等待用户决策

四、架构融合实践建议

分层解耦设计 [AG-UI前端] ↔ [A2A网关] ↔ [MCP服务群] ↔ [基础智能体群]

协议转换中间件:解决不同框架(LangGraph/CrewAI)的适配问题

企业级安全加固:在MCP层实现数据脱敏,A2A层添加OAuth2鉴权

好了,今天就分享到这里,如果本次分享对你有所帮助,记得告诉身边有需要的朋友,"我们正在经历的不仅是技术迭代,而是认知革命。当人类智慧与机器智能形成共生关系,文明的火种将在新的维度延续。"在这场波澜壮阔的文明跃迁中,主动拥抱AI时代,就是掌握打开新纪元之门的密钥,让每个人都能在智能化的星辰大海中,找到属于自己的航向。

版权声明:倡导尊重与保护知识产权。未经许可,任何人不得复制、转载、或以其他方式使用本站《原创》内容,违者将追究其法律责任。本站文章内容,部分图片来源于网络,如有侵权,请联系我们修改或者删除处理。