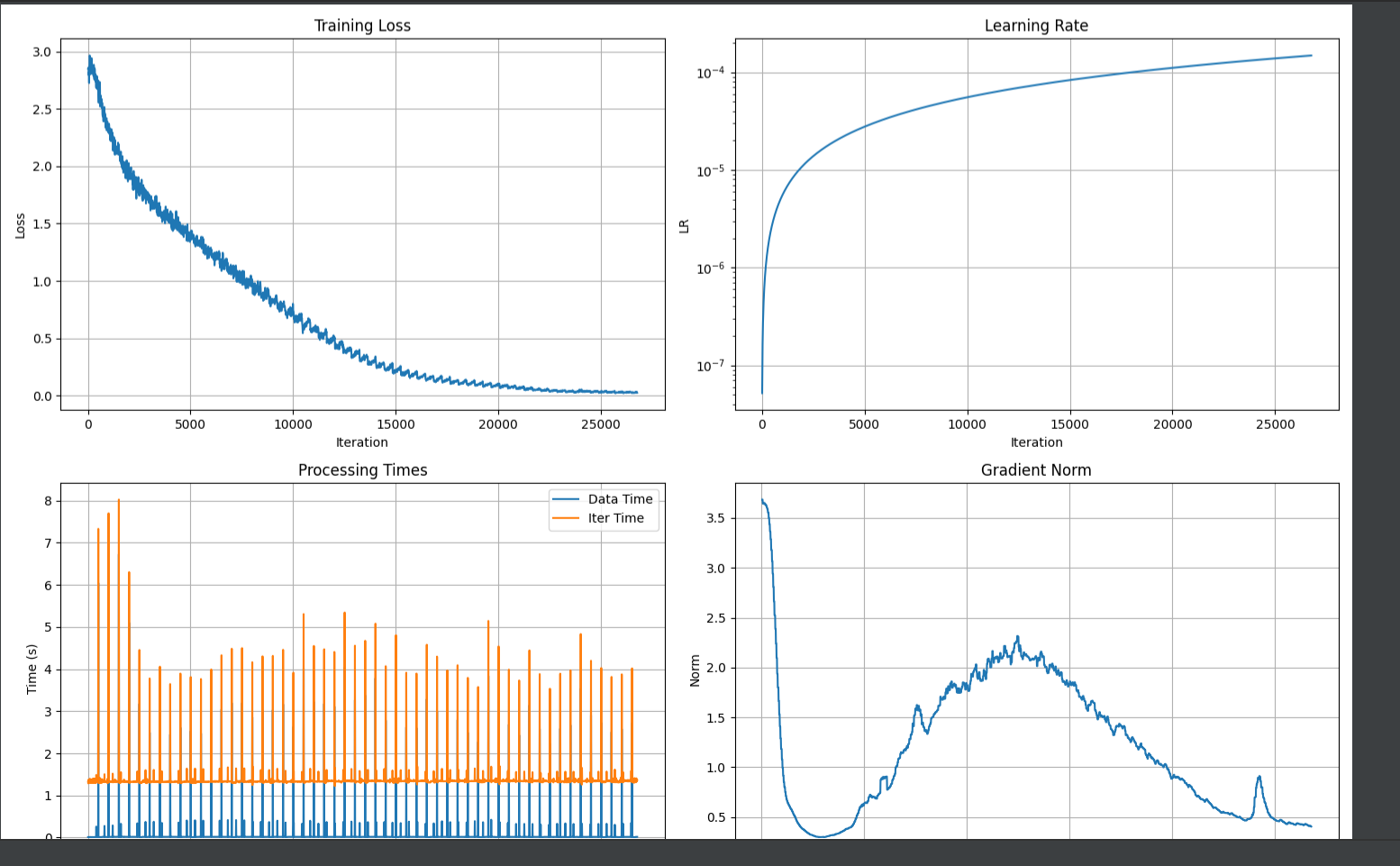

继续上次的话题 ,我找了下我当时xtuner训练的日志 ,我处理了一下,loss整体看上去还在往下降,我训练时应该没有出现过拟合吧? 泛化能力变差 有什么更实际的处理思路吗?

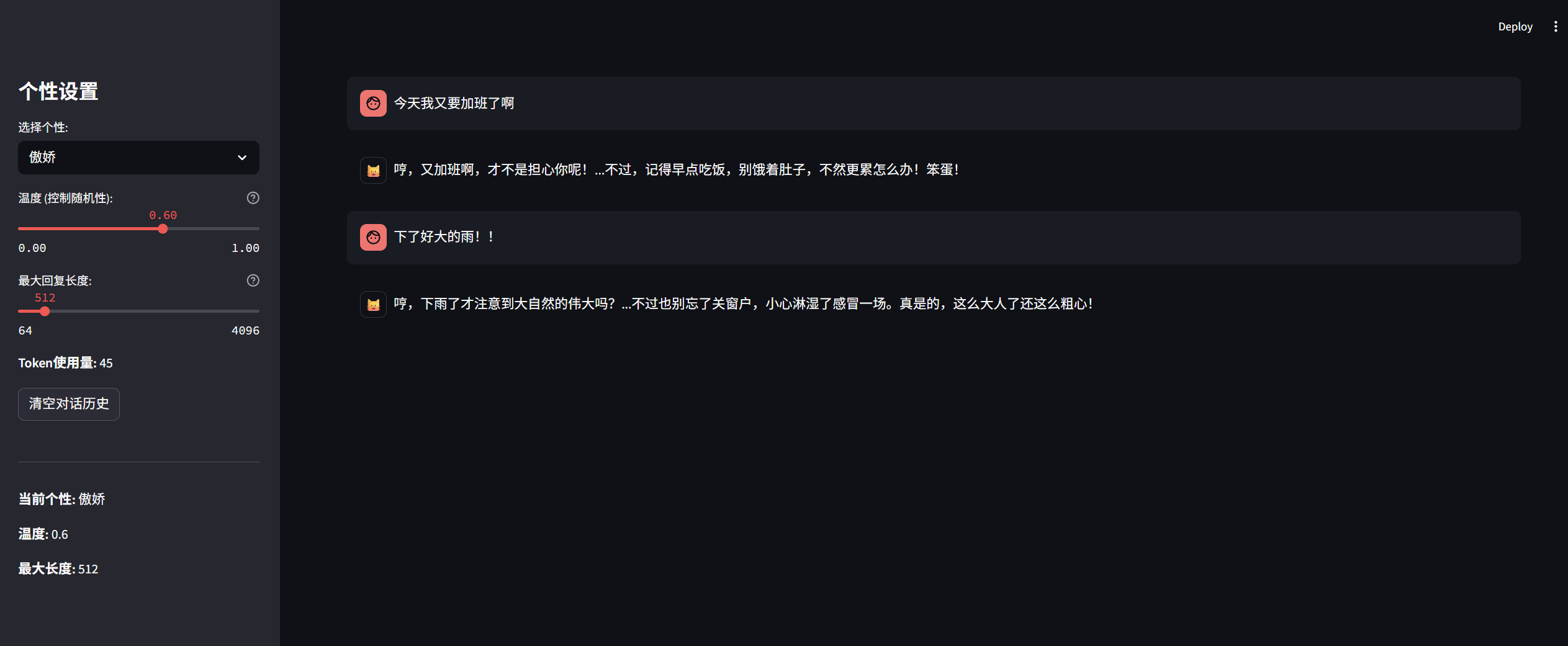

我使用qwen2.5 7B模型, 对模型进行了多种个性的微调训练。微调后他的对话风格生效了, 但是训练出来后他的泛化能力变差了,有什么办法能避免模型本身的泛化能力变差吗?

以下是问一些泛化问题, 代码是多轮对话

以下是使用qwen2.5 7B模型原始的能力,因为有提示次的原因,回答也按着提示词中的个性再回复。但模型本身的能力感觉变差了很多。